Study Design에는 크게 다음 두 가지 타입이 있다.

1. Observational studies

- 'Nature'가 factor of interest에 노출될 사람과 비노출될 사람을 정한다.

- 보통 association을 증명하고 싶을 때 사용한다.

- Association은 원인을 암시할 수도 있고, 아닐 수도 있다.

2. Experimental studies

- 실험설계자가 노출/비노출을 결정한다.

- 보통은 원인을 증명하고 싶을 때 사용한다.

❗위 두 스터디 디자인에 대해서 조금 더 자세하게 살펴보도록 하자.

Ⅰ. Observational studies

우리 말로 관측연구로 불리는 이 디자인은 보통 다음과 같이 나눌 수 있다.

① cross-sectional study, ② case-control study, ③ prospective (or cohort) study

- Cross-sectional study: measurements는 같은 시간에 측정해야 함. 예를 들어 혈압과 coronary disease의 연관성을 알고 싶을 때, 혈압과 coronary disease에 대한 테스트는 동시에 이루어져야 함. 인과를 알 수는 없음.

- Case-control study: 연구자가 질병에 걸린 case 그룹과 정상인 control 그룹을 나눠 조사를 통해 위험인자의 유무를 결정함. 예를 들면 폐암에 걸린 case 그룹과 정상인 control 그룹을 나눠 각 그룹에서 흡연(위험인자)의 유무를 확인함. 희귀병 연구에 유용함. 보통 retrospective (후향적) 연구.

- Prospective (or cohort) study: 연구자가 질병이 없는 정상 코호트 집단에서 위험인자를 가진 사람들과 위험인자가 없는 사람들을 나누어서 추적 관찰하는 연구. 인과관계를 파악에 유용함. 측정도구의 오류나 recall 오류에 의한 subject bias가 덜함. 우리 말로는 전향연구이고 longitudinal study로도 불린다.

정리하면 Case-control 연구와 Prospective 연구의 가장 큰 차이점은 "sampling"에 있다.

Case-control 연구의 경우 diseased 그룹과 nondiseased 그룹에 속하는 사람들을 샘플링하는 것이고,

Prospective 연구의 경우 위험인자에 노출된 사람과 노출되지 않은 사람들을 샘플링 하는 것이다.

Prospective (전향, 코호트) 연구가 질병의 원인에 대해서는 retrospective(후향) 연구보다 더 강한 증거가 된다. 단점은 물론 비싸다.. 많은 시간이 필요하고, 어렵다.

Ⅱ. Experimental studies

Experimental 연구는 intervention의 효과를 테스트 하는 것이고,

health field에서는 Clinical trial (임상 시험) 이라 보면 된다.

Clinical trial에서는 연구자가 참가자들이 어떤 그룹에 속할지에 관여하게 된다. (연구자가 직접 참가자들을 지정하는 것보다는 어떤 방식으로 참가자들을 각 그룹에 배정할지 결정하는 방법에 관여함)

'STATISTICS' 카테고리의 다른 글

| 가능도비란? Likelihood Ratio - 기초 (0) | 2023.02.19 |

|---|---|

| 베이지안 확률 (Bayesian Probability) - 기초 (0) | 2023.02.12 |

| 다중비교 (Multiple comparisons test) [1] (0) | 2023.02.01 |

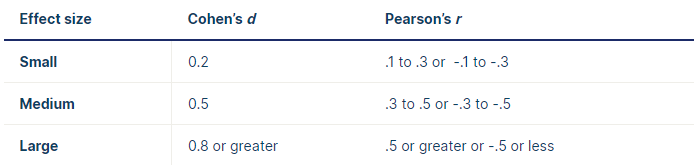

| Effect size : 효과 크기와 유의확률 (p-value) (2) (0) | 2022.12.25 |

| Effect size : 효과 크기와 유의확률 (p-value) (1) (1) | 2022.12.25 |